Die Null ist eine Zahl, die auf der Zahlenreihe genau zwischen den positiven und negativen Zahlen liegt. Die Null wird zusammen mit den positiven natürlichen Zahlen (1, 2, 3, 4…) und den negativen Zahlen (…-4,-3,-2,-1) als ganze Zahl betrachtet.

Die Null ist eine besondere Zahl innerhalb der ganzen Zahlen, da sie die einzige ganze Zahl ist, die weder positiv noch negativ ist. Sie ist auch die einzige ganze Zahl, die weder eine Primzahl noch eine zusammengesetzte Zahl ist. Sie gilt als gerade Zahl, da sie durch 2 teilbar ist und keinen Rest hat. Die Null ist das additive Identitätselement in verschiedenen Systemen der Algebra, und die Ziffer „0“ wird als Platzhalterwert in Positionsnotationssystemen zur Darstellung von Zahlen verwendet.

Die Null hat viele interessante Eigenschaften, die sie für Mathematiker interessant machen. Wenn man Null von einer beliebigen Zahl addiert oder subtrahiert, bleibt die Zahl gleich. Multipliziert man 0 mit einer beliebigen Zahl, ist das Ergebnis 0. Jede Zahl, die zur nullten (0.) Potenz erhoben wird, ist 1, also 20=1 und 560=1. In der traditionellen Algebra ist die Division durch 0 undefiniert, so dass keine Zahl durch 0 geteilt werden kann. Die Zahl 0 ist auch ein Element der reellen Zahlen und der komplexen Zahlen.

Geschichte der Zahl 0

Woher kommt die Idee der Null? Heutzutage erscheint sie uns intuitiv: Die Null ist eine Zahl, die für eine Nullmenge steht – ein Nichts. Wir sehen Nullen überall in der Gesellschaft, und wir verstehen natürlich, was sie bedeuten und wie sie mathematisch manipuliert werden können. Historisch gesehen hat es jedoch lange gedauert, bis das Konzept der Null als Gegenstand der Mathematik allgemein anerkannt wurde, und viele haben im Laufe der Geschichte argumentiert, dass die Zahl Null nicht existiert oder dass die Idee der Null ein inkohärentes Konzept ist.

Viele antike Gesellschaften hatten kein explizites Konzept für die Menge der Null oder eine bestimmte Ziffer, die für ihre Darstellung verwendet wurde. Sowohl die alten Ägypter als auch die Babylonier hatten eine Vorstellung von einer Nullmenge und einem Bedarf an Platzhalterwerten in der Zahlendarstellung, aber sie entwickelten nie eine eigene Ziffer oder ein Konzept, um diese Menge oder diesen Platzhalterwert darzustellen. Die altägyptischen Zahlensysteme waren rein bildlich und hatten keine Positionswerte, während die alten Babylonier Leerzeichen zwischen den Zahlen verwendeten, um Positionswerte darzustellen.

Die Maya hatten ein explizites Konzept der 0 und verfügten über eine eindeutige Ziffer zur Darstellung des Konzepts und zur Verwendung als Platzhalterwert in ihrem vigesimalen (Basis 20) Kalendersystem. Während die Maya, Olmeken und andere vorkolumbianische Gesellschaften zu den ersten in der Geschichte gehörten, die ein explizites und ausgefeiltes Verständnis der Zahl 0 hatten, beeinflussten diese Systeme die Gesellschaften der Alten Welt in Europa nicht weiter.

Die alten Griechen hingegen hatten eine komplizierte Beziehung zur Null. Sie hatten kein Symbol für ihren Begriff oder für sie als Platzhalterwert, weil sie unsicher waren, ob die Zahl 0 als etwas wirklich Existierendes betrachtet werden konnte. Wie, so fragten sie, könnte etwas (eine Zahl) nichts (Null) sein? Für die Griechen wurden die natürlichen Zahlen (1, 2, 3, 4,…) aus unserem Verständnis von diskreten Einzelobjekten in der Welt abgeleitet. Aristoteles selbst vertrat die berühmte Ansicht, dass die 0 nicht existiert, da sie eine Leere oder ein Nichts darstellt, und eine echte Leere oder ein Nichts kann nicht existieren.

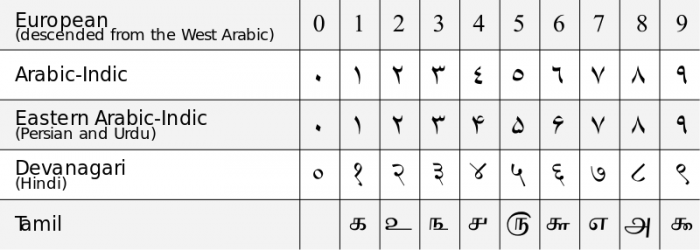

Die Chinesen verstanden die „0“ als Platzhalter für ihr Zählsystem, aber sie betrachteten die „0“ nicht als eine bestimmte Zahl, sondern nur als ein nützliches Symbol. Das allgemeine Verständnis der 0 als eindeutige Zahl und als Ziffer für Positionsnotationssysteme stammt aus Indien aus dem 6. Jahrhundert n. Chr. Die indischen Mathematiker dieser Zeit entwickelten die ersten dezimalen (Basis-10-) Notationssysteme, die die 0 als eindeutige Ziffer enthielten, und waren sich der einzigartigen mathematischen Eigenschaften der Null bewusst. Im 11. Jahrhundert n. Chr. hatte sich die Idee der Null durch den Einfluss islamischer Mathematiker, die in Spanien unter dem Umayyaden-Kalifat lebten, in Westeuropa verbreitet, und es entstand das heutige arabische Zahlensystem der Dezimalnotation. Die erste Verwendung des englischen Wortes „zero“ geht auf das Jahr 1589 zurück.

Mathematische Eigenschaften der Null

Die Zahl Null spielt in fast allen Bereichen der Mathematik eine wichtige Rolle. Die Null ist die kleinste nichtnegative ganze Zahl und hat keine natürliche Zahl, die ihr vorausgeht. Da 0 eine ganze Zahl ist, ist sie auch eine rationale Zahl, eine reelle Zahl und eine komplexe Zahl. In der Mathematik wird 0 als eine Menge betrachtet, die einem Nullbetrag entspricht. Man könnte sagen, dass die Null die „Menge“ ist, die eine Menge besitzt, die keine Mitglieder hat.

In der Algebra

In der elementaren Algebra wird die Null oft so ausgedrückt, dass sie in der Mitte der Zahlenreihe liegt. Die Zahl 0 gilt als gerade Zahl, da sie ein ganzzahliges Vielfaches der Zahl 2 ist (2×0=0). 0 ist keine Primzahl, weil sie unendlich viele Faktoren hat, und sie ist keine zusammengesetzte Zahl, weil kein Produkt zweier Primzahlen gleich der Zahl 0 ist.

In Bezug auf die 4 arithmetischen Hauptoperatoren (+, -, ×, ÷) und die Exponentenoperation verhält sich die Zahl 0 nach folgenden Regeln:

- Addition: x+0=0+x=x. Null wird als additives Identitätselement betrachtet, da jede Zahl plus oder minus Null gleich dieser Zahl ist

- Subtraktion: x-0=x und 0-x=-x

- Multiplikation: x⋅0=0⋅x=0. Jede Zahl mal 0 ist auch gleich 0.

- Division: 0/x=0, außer wenn x=0. x/0 ist eine mathematisch undefinierte Größe, da 0 keine multiplikative Umkehrung hat (keine Zahl mal 0 ergibt 1).

- Exponenten: x0=1, außer wenn x=0. Es wird seit langem darüber diskutiert, ob 00 undefiniert oder ein wohlgeformter Ausdruck ist. Für alle positiven x ist 0x=0.

In Ausdrücken, die Grenzwerte beinhalten, kann die Menge 0/0 im Zusammenhang mit der Darstellung von Grenzwerten rationaler Funktionen wie f(x)/g(x) auftauchen. In diesen Fällen ist 0/0 nicht undefiniert, sondern stellt eine unbestimmte Form dar. Das bedeutet nicht, dass der Grenzwert undefiniert ist, sondern dass er mit einer anderen Methode berechnet werden muss, z. B. durch die Ermittlung von Ableitungen. Es gibt einige algebraische Modelle, bei denen die Division durch Null eine definierte Größe ergibt, wie z. B. die projektiv erweiterte reelle Linie oder die Riemannsche Kugel.

In der Mengenlehre

In der Mengenlehre entspricht die Zahl 0 der Kardinalität der „leeren Menge“ oder der „Nullmenge“ (üblicherweise dargestellt als {} oder {∅}. Die Kardinalität einer Menge ist die Anzahl der Elemente in dieser Menge, wenn man keine Orangen hat, dann hat man eine Menge von 0 Orangen (eine leere Menge von Orangen).

Die Null wird in der Mengenlehre oft als Ausgangspunkt verwendet, um den Rest der natürlichen Zahlen zu konstruieren. Diese von-Neumann-Konstruktionen, benannt nach dem berühmten Universalgelehrten John von Neumann, konstruieren die natürlichen Zahlen, indem sie 0={} definieren und eine Nachfolgefunktion S(a) = a ∪ {a} definieren. Die Gesamtheit der natürlichen Zahlen kann aus den rekursiven Anwendungen der Nachfolgefunktion, beginnend mit der leeren Menge, konstruiert werden:

0 = {}

1 = 0 ∪ {0} = {0} = {{}}

2 = 1 ∪ {1} = {0,1} = {{}, {{}}}

3 = 2 ∪ {2} = {0, 1, 2} = {{}, {{}}, {{}, {{}}}}

und so weiter. Nach diesem Muster kann man die gesamte unendliche Menge der natürlichen Zahlen konstruieren. Auf diese Weise kann man sagen, dass jede natürliche Zahl der Menge entspricht, die alle natürlichen Zahlen vor ihr enthält.

In der Physik

Im Zusammenhang mit quantitativen Messungen in der Physik wird die 0 als Grundlinie betrachtet, von der aus alle anderen Messungen von Einheiten vorgenommen werden. Sehr oft entspricht die Basislinie 0 einer physikalisch bedeutsamen Größe, die sich von allen anderen Messgrößen auf natürliche Weise unterscheidet.

In der Kelvin-Skala zum Beispiel entspricht eine Temperatur von 0 K dem absoluten Nullpunkt – der kältesten Temperatur, die physikalisch möglich ist. In der Celsius-Temperaturskala ist 0 °C als der Gefrierpunkt von Wasser bei atmosphärischem Druck definiert. Im Zusammenhang mit Dynamik und Elektromagnetismus wird ein Wert von 0 für die Position angegeben, in der ein System die geringstmögliche Menge an potenzieller Energie hat. So wird beispielsweise dem Grundzustand eines Atoms, dem niedrigstmöglichen Energieniveau für die Elektronen im Atom, häufig der Wert 0 zugewiesen.

Auch in der Kinematik wird das Bezugssystem, von dem aus Bewegungsbeobachtungen gemacht werden, so definiert, dass sein Mittelpunkt auf dem Ursprung der Koordinatenachse im Punkt (0, 0) liegt. Im Fall von konservierten Größen wie Masse-Energie, Impuls und Drehimpuls ist der Gesamtbetrag der Änderung der konservierten Größen in einem isolierten System immer gleich 0.

In der Informatik

Computer speichern Informationen in Form von bit-langen Sequenzen von 1en und 0en. In dieser binären Darstellung entspricht die 0 einer „Aus“-Stellung und steht im Gegensatz zur „Ein“-Stellung, die mit 1 bezeichnet wird. Ein Wert von 0 in einem elektrischen Schaltkreis bedeutet, dass der Schaltkreis ausgeschaltet ist und kein elektrischer Fluss stattfindet. In ähnlicher Weise definieren viele Computerlogiken „0“ als das Zeichen, das einen falschen Wahrheitswert darstellt.

In Computerdatenbanken werden die Elemente eines Arrays unter Verwendung eines nullbasierten Zählsystems gezählt. Das bedeutet, dass bei einer Menge mit n Elementen die Elemente Indizes haben, die mit 0 beginnen. Ein Element mit der Indexnummer 0 ist also das erste Element in der Reihe, eine Indexnummer von 1 entspricht dem zweiten Element usw. Im Allgemeinen hat der n-te Term einer Menge eine Indexnummer, die n-1 entspricht. Dieses Zählsystem kann neue Programmierer verwirren, die es gewohnt sind, intuitiv Indexwerte zuzuweisen, die mit 1 beginnen.